Resulta refrescante ver cómo sesenta «inteligencias artificiales» fallan una pregunta sencilla:

Sally tiene tres hermanos. Cada hermano tiene dos hermanas. ¿Cuántas hermanas tiene Sally?

Una, obvio.

La mayoría de los LLM (siglas de «Large Language Model», modelo de lenguaje grande) responden «seis». Ven dos números, la palabra «cada» y devuelven su producto porque es lo que suele pasar siempre que aparecen dos números cerca de la palabra «cada».

Un modo de fallo trivial. Las interesantes son las demás. Varias responden «tres». Alguna dice «dos». También «cero». Otra dice «doce» y otra más opta por «dieciocho». Varias no responden y alguna entra en un bucle como aquellos en los que entraban los robots de la ciencia ficción clásica ante preguntas paradójicas lanzadas para desactivarlos. Y una, pobrecita, se lanza con un fragmento, al parecer aleatorio, de un cuento breve sobre Sally, sus hermanas y sus hermanos.

Ni una sola da la respuesta correcta, porque ni una sola tiene un modelo mental de la realidad. Pero esto tendría que ser obvio para los genios que crean las IA, ¿verdad?

¿Verdad?

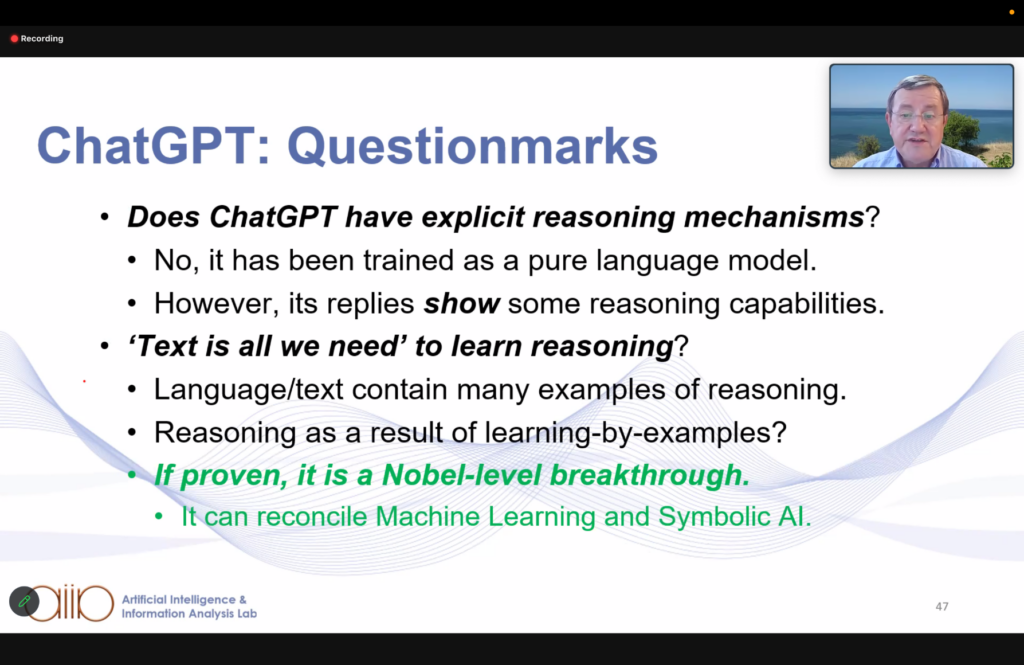

Pensaba que era obvio, pero hay, al parecer, al menos un tipo de actor que cree sinceramente que no. Germán Vidal (@theheruman@paquita.masto.host), profesor e investigador en el Valencian Research Institute for Artificial Intelligence, resume ese punto de vista con una imagen extraída de una charla en la que, precisamente, estaba en ese momento:

No siendo un experto en inteligencia artificial, esto me parece poco probable. Pensemos solo en el conocido aforismo «el papel lo aguanta todo». Viene a significar que podemos describir con palabras cualquier situación, real, inventada o intermedia. Podemos afirmar una cosa y su contraria en el espacio de una misma frase. La mera existencia de una descripción textual no tiene ninguna relevancia sobre el mundo real. Confiar en que, estadísticamente, la verdad saldrá a flote equivale a suponer que el corpus de textos creados por la especie humana desde que comenzó su romance con la palabra escrita es representativo de todos los textos posibles. Y que, además, tendemos a ser objetivos, a reflejar la realidad y a no tener sesgos.

Ninguna de las dos cosas es cierta. Todos los textos escritos pueden ser muchos, pero no son más que una gota en el océano de todos los textos posibles. Y no somos interlocutores fiables: ni siquiera la ciencia, la parte del saber humano en principio más fiable y resistente a las desviaciones con la realidad, se libra de falsedades.

Esto, por cierto, no excluye que el propio cerebro humano genere lenguaje por medio de un proceso similar al de los LLM. Quién sabe si, al menos en parte, no somos también loros estocásticos, por usar el afortunado término de la lingüista computacional Emily Bender. Aunque los seres humanos, junto con los chimpancés, los córvidos, los propios loros y tantas especies más, somos capaces de operacionalizar la información sobre el mundo.

Dicho de otra manera: uno podría dudar de la ciencia e imaginarse que todo es un constructo abstracto con ínfulas de consistencia. Pero la ciencia es la base de la tecnología, y la tecnología funciona. El fuego calienta el agua, el agua discurre montaña abajo. Somos nosotros quienes hemos construido todo eso. La ciencia puede falsearse, pero la tecnología no, trucos de magos o timadores aparte.

¡Qué debate más interesante! Mi argumento original no pretendía tomar una tecnología (los LLM) y reírme de ella. Es obvio que tiene usos completamente válidos. Lo que intento remarcar es que cada vez me resulta más increíble que las fuerzas que intentan comercializar estos modelos deben ser conscientes de que, con toda probabilidad, no hacen ni son lo que prometen. Pero siguen adelante con la pantomima. Como una respuesta que di, en otro punto de la conversación:

In a response further down the thread I stated the target for my criticism, which is not the models per se, but its Silicon Valley peddlers, who are trying to bundle them everywhere on sight and, at the same time, trying to leave the false impression that “this is it”, singularity-wise. You wouldn’t find these kind of benchmarks if it was so clear to everyone involved that LLM cannot and will not do that.

https://social.brucknerite.net/@brucknerite/111052121339730611 (El mensaje puede haber sido borrado desde la publicación.)

Mi amigo Txapulín (@txapulin@paquita.masto.host) nos deja en la conversación una nota intrigante:

@the_heruman @brucknerite Parece que el modelo de IA de Google (LaMDA) está más orientado a esa comunicación entre distintas inteligencias, y por eso Blake Lemoine, ingeniero de Google, llegó a pensar que era autoconsciente. Dice que LaMDA era capaz de ver películas, siempre que estuviera en el catálogo de YouTube, y opinar sobre ellas. Eso salió antes de que se pusiera de moda ChatGPT, pero me parece sospechoso que Google esté callado respecto a LaMDA.

https://paquita.masto.host/@txapulin/111052123863194004 (El mensaje puede haber sido borrado desde la publicación.)

Por el criterio de parsimonia, esto tampoco será nada. Hasta que un día lo sea.

#leyendo

https://tldr.nettime.org/@tante/111051594557347916 #by @tante #via @rb3n